Datenspeicherung und die Lebensdauer von Datenträgern

Forschungsdaten können auf verschiedenen Wegen gespeichert werden, z.B. auf Rechnern, mobilen…

Was High Performance Computing ist

Das Hochleistungsrechnen (HPC-High Performance Computing) hat in den vergangenen Jahren in vielen Wissenschaftsfeldern an Bedeutung gewonnen. HPC wird als eine Schlüsseltechnologie in Wissenschaft und Wirtschaft gesehen. Während numerische Simulationen aus Natur- und Ingenieurwissenschaften auf HPC-Systemen eine lange Historie aufweisen, wächst neben der Simulation auch die Bedeutung von Analysen riesiger Datenmengen und rechenintensiven Anwendungen rund um die Künstliche Intelligenz.

HPC ermöglicht es, komplexe wissenschaftliche Fragestellungen zu beantworten und Einblicke in bisher unerforschte Bereiche und Systeme zu nehmen. Extrem anspruchsvolle Rechenanwendungen, deren Berechnung auf Grund von Komplexität oder Umfang auf normalen Computer nicht mehr umsetzbar sind, fallen in den Bereich des Hochleistungsrechnens. Grundsätzlich stellen die HPC-Systeme ein Vielfaches an Rechenleistung und Speicherkapazität herkömmlicher Desktop- und einfacher Server-Systeme zur Verfügung. Das wissenschaftliche Rechnen, ein interdisziplinärer Ansatz zur Entwicklung von Modellen, Algorithmen und Software, spielt dabei eine wichtige Rolle.

Hochleistungsrechner, die riesige Datenmengen verarbeiten und komplexe Berechnungen umsetzen können, werden in einer Vielzahl von Forschungsfeldern verwendet. Im Folgenden wird beispielhaft ein Ausschnitt der Einsatzmöglichkeiten aufgezeigt.

In der Klimaforschung werden Hochleistungsrechner zur genaueren Vorhersage von Wetter, Naturkatastrophen und für die Simulationen zum Klimawandel verwendet. Auch simulieren Klimaforschende das Verhalten der Ozeane und der Atmosphäre. So lassen sich Klimaveränderungen modellieren und besser verstehen.

In der Biomedizin nutzen Forscherteams das Hochleistungsrechnen zur Erforschung von Biomolekülen und Proteinen in menschlichen Zellen, um neue Verfahren, Medikamente und medizinische Therapien zu entwickeln und damit unsere Lebensqualität zu verbessern. In der Hirnforschung wird HPC zur Modellierung und Simulation des menschlichen Gehirns in hohen Auflösungen eingesetzt.

Auch für die Entwicklung einer nachhaltigeren Landwirtschaft, etwa zur Optimierung bei der Lebensmittelerzeugung und der Analyse von Nachhaltigkeitsfaktoren, wird HPC-Technik angewendet. Ebenso auch für Untersuchungen zu einer effizienten Bewirtschaftung von Wasserbestände und Agrarressourcen.

Im Bereich Energie arbeiten Forschende bei der Entwicklung von Anlagen zur Energieerzeugung aus erneuerbaren Energiequellen, bei Untersuchungen zu neuen Werkstoffen für Solarzellen oder für die Optimierung von Turbinen zur Stromerzeugung mit leistungsstarken Hochleistungsrechnern.

Ebenso hat das HPC in der Stadtplanung Einzug gehalten, wo Fragen zu einer effizienten Steuerung der Verkehrsinfrastruktur zu lösen sind. Durch Simulation auf Hochleistungsrechnern werden Verkehrsströmungen, unter Berücksichtigung der Ausbreitung von Schadstoffen untersucht. Ebenso können Luftströmungen in den Großstädten berechnet werden.

Ein Hochleistungsrechner ist aber weit mehr als nur ein großer und schneller Computer. Es bedarf Infrastrukturen für die Energieversorgung, Kühlung, Rechnerräume sowie intelligente Sicherheitskonzepte. Nicht zu vergessen sind HPC-Experten, die diese Systeme betreiben. Hochleistungsrechnen bedeutet innovative Methoden zur Modellierung, Simulation, Optimierung von Anwendungen und Prozessen.

Die Architektur der Hochleistungsrechner ist auf parallele Verarbeitung ausgerichtet, um den sehr hohen Rechenaufwand schnell zu verarbeiten, daher spricht man auch von Parallelrechnern. Als Betriebssystem kommt Linux zum Einsatz, da dieses im HPC-Bereich die breiteste Unterstützung bietet.

Ein Hochleistungsrechner besteht - vereinfacht ausgedrückt - aus einer großen Anzahl gekoppelter, paralleler Rechner, den sogenannten Knoten (Compute Nodes). Die wiederum enthalten eine bestimmte Anzahl von Kernen/Cores (CPU-Central Processing Unit, der Prozessor) und GPUs (Graphics Processor Unit, ein Grafikprozessor). Die Rechenleistungen der Hochleistungsrechner werden in Teraflops (TFLOPS) und Petaflops (PFLOPS) angegeben.

Beispielsweise verfügt der Höchstleistungsrechner „HAWK“ des Höchstleistungsrechenzentrum Stuttgart über 26 PetaFlops und über mehr als 5.500 Knoten mit 720.000 Kernen. Damit ist er einer der leistungsstärksten Rechner in Europa, wie auch im virtuellen Rundgang erklärt wird.

Eine zweite Veranschaulichung: ein Forschungshochleistungsrechner in Baden-Württemberg, Justus II, entspricht mit seinen 33.696 Kernen einem System von ca. 15.000 herkömmlichen Laptops. Bei einer besonders großen Anzahl an Prozessoren, die auf gemeinsame Peripheriegeräte und einen teilweise gemeinsamen Hauptspeicher zugreifen können, wird auch von Supercomputer gesprochen. Um einen Eindruck von den leistungsstärksten Supercomputern in der Welt zu bekommen, lohnt sich ein Blick in die Top500.

Die Parallelrechner sind mit dem Ziel konstruiert, die extrem anspruchsvollen Rechenaufgaben, auch Jobs genannt, in einzelne Teilaufgaben zu zerlegen. Durch ein Job-Management-System werden sie auf die Knoten verteilt und dort gleichzeitig ausgeführt. Die Aufgabenverteilung und die Synchronisation sind wichtige Aspekte für die Rechenleistung. Die Kommunikation zwischen laufenden Job-Teilen, die auf verschiedenen Knoten laufen, geschieht meist mittels eines Message-Passing-Interface (MPI). Um eine schnelle Kommunikation zwischen den einzelnen Prozessen zu erzielen, sind die Knoten mit einem extrem schnellen Hochgeschwindigkeitsnetzwerk, z.B. einem Infiniband, verbunden.

Durch ein parallel verteiltes Dateisystem, bei dem jeder Knoten direkt auf das Dateisystem zugreifen kann, wird die Rechnerleistung gesteigert. Das Dateisystem befindet sich auf einem Speichermedium, das von allen Knoten direkt erreichbar ist. Hochleistungsrechner können von mehreren Nutzern gleichzeitig verwendet werden. Allerdings konkurrieren diese dann bei der Erledigung der eingereichten Jobs um die Knoten, Speicher, Netzwerke usw. Um einen HPC-Cluster fair und effizient zu nutzen, wird ein HPC-Ressourcenmanager, auch Workload-Manager genannt, eingesetzt. Er kann Rechenressourcen nach Plan automatisiert zuweisen und übernimmt auch Management-, Monitoring- und Reporting-Aufgaben. Die Hochleistungsrechner stellen keine Backup-Speicher für längere Aufbewahrung dar, da damit die Rechenleistung stark einschränkt werden würde. Dafür werden verbundene Speicherinfrastrukturen eingesetzt.

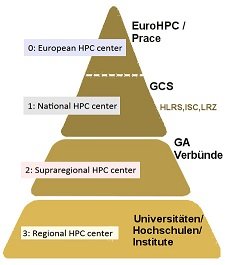

HPC-Leistungspyramide

Die Ebenen 0 bis 3 (es wird auch von Tier – deutsch: Stufe, Schicht – gesprochen) spiegeln die zunehmend steigende Rechenkapazität und den steigenden Grad der Parallelisierung der Simulationscodes und der Menge der verarbeiteten Daten wider. Auf der Basisebene 3 besteht ein breiteres Angebot an HPC-Rechensystemen für Forschende und dem wissenschaftlichen Nachwuchs, die hier auch verstärkte Unterstützung erhalten.

Um internationalen Forschenden aus Wissenschaft und Industrie den Zugang zu Computer- und Datenverwaltungsressourcen und -diensten für ihre umfangreichen wissenschaftlichen und technischen Anwendungen auf höchstem Leistungsniveau zu ermöglichen, besteht die europäische Initiative Prace (Partnership for Advanced Computing in Europe) mit 26 europäischen Mitgliedsländern.

Auf europäische Ebene wurde das Gemeinsame Unternehmen für europäisches Hochleistungsrechnen zur Umsetzung der Initiative zum europäischen Hochleistungsrechnen gegründet. Die EuroHPC ist eine öffentlich-private Partnerschaft zwischen der Gemeinschaft, den teilnehmenden Mitgliedstaaten, der Vereinigung „European Technology Platform for High Performance Computing” (ETP4HPC) und der Vereinigung „Big Data Value Association” (BDVA). Die Mitglieder des EuroHPC verfolgen das Ziel, Höchstleistungsrechnen in Europa zu stärken und die Entwicklung von Supercomputern voranzutreiben. Basierend auf wettbewerbsfähiger, europäischer Technologie, ist geplant eine gesamteuropäische Supercomputer-Infrastruktur im Exascale-Bereich für die Verarbeitung riesiger Datenmengen zu entwickeln und damit Forschungs- und Innovationsaktivitäten zu unterstützen. Weiteres zu Supercomputer in Europa

In Deutschland ist das (GCS) (Gauß Centre for Supercomputing) das Center, das die deutschen Interessen in der PRACE-Initiativen vertritt. Das GCS ist ein Zusammenschluss der drei bedeutendsten Höchstleistungsrechenzentren in Deutschland, das HLRS (Höchstleistungsrechenzentrum der Universität Stuttgart), das JSC (Jülich Supercomputing Centre) und das LRZ (Leibniz Rechenzentrum, Garching bei München). Ziel des GCS ist die Förderung und Unterstützung des wissenschaftlichen Höchstleistungsrechnen. Die kontinuierliche Weiterentwicklung dieser drei Supercomputing-Zentren wird durch die Förderung des Bundesministeriums für Forschung und Bildung sowie den Landesministerien gesichert.

Die Gauß-Allianz, gemeinnütziger Verein zur Förderung von Wissenschaft und Forschung, setzt sich aus den großen wissenschaftlichen Rechenzentren in Deutschland sowie anderen HPC-relevanten wissenschaftlichen Einrichtungen zusammen. Sie fördert das Wissenschaftsthema HPC als eigenständige strategische Forschungsaktivität und sorgt für eine verbesserte internationale Sichtbarkeit der deutschen Forschungsanstrengungen auf diesem Gebiet. Der Schwerpunkt liegt auf der Erforschung und Entwicklung von Strategien zur Verbesserung der Effizienz, Anwendbarkeit und vereinfachten Nutzbarkeit des Hoch- und Höchstleistungsrechnens.

Die Gemeinsame Wissenschaftskonferenz (GWK) von Bund und Ländern hat sich 2018 darauf geeinigt, ein Nationales Hochleistungsrechnen (NHR) dauerhaft zu etablieren. Mit dem Nationalen Hochleistungsrechnen werden die fachlichen und methodischen Stärken von Hochleistungsrechenzentren in einem nationalen Verbund weiterentwickelt.

Mit dem GWK-Beschluss vom 13. November 2020 wurden acht Rechenzentren der 2.Ebene der Leistungspyramide in die Förderung des NHR aufgenommen. Vorausgegangen war eine Empfehlung des Strategieausschusses auf Basis eines wettbewerblichen und wissenschaftsgeleiteten Auswahlverfahrens.

Das Deutsche Klimarechenzentrum (www.dkrz.de) ist eine nationale Serviceeinrichtung und ein wichtiger Partner der Klimaforschung. Die Hochleistungsrechner, Datenspeicher und Dienste bilden die zentrale Forschungsinfrastruktur für die simulationsbasierte Klimawissenschaft in Deutschland.

In Baden-Württemberg ist, im Rahmen eines Umsetzungskonzeptes, durch die Initiative bwHPC (High Performance Computing in Baden-Württemberg) eine landesweite Hochleistungsrechner-Infrastruktur aufgebaut worden und wird in Zukunft mit weiteren Speicherinfrastrukturen ausgebaut. Die Besonderheit der Initiative, die auch unter bwHPC-S5 (Scientific Simulation and Storage Support Services) bekannt ist, liegt darin, dass auch hochschulübergreifende, nutzerunterstützende Maßnahmen angeboten werden, um einem möglichst breiten wissenschaftlichen Nutzerkreis, die bereitgestellten Ressourcen zu eröffnen. Es ist sozusagen eine Brücke zwischen Forschenden und IT gespannt worden.

Das HKHLR, dem die fünf hessischen Universitäten Darmstadt, Frankfurt, Gießen, Kassel und Marburg angehören, ist ein Bestandteil des hessischen HPC-Ökosystems. Kernaufgabe ist die Unterstützung der hessischen Wissenschaftlerinnen und Wissenschaftler bei der effizienten Nutzung von Hochleistungsrechnern.

Das Hauptziel von KONWIHR besteht darin, technischen Support für den Einsatz von Hochleistungscomputern bereitzustellen und deren Bereitstellungspotenzial durch Forschungs- und Entwicklungsprojekte zu erweitern. Eine enge Zusammenarbeit zwischen Disziplinen, Benutzern und teilnehmenden Rechenzentren sowie eine effiziente Übertragung und schnelle Anwendung der Ergebnisse sind wichtig.

Das Land Nordrhein-Westfalen verfügt über ein ausdifferenziertes Ökosystem von Hochleistungsrechenanlagen an fast allen Universitätsstandorten. Die Arbeitsgruppe HPC der Digitalen Hochschule NRW (HPC.NRW) hat vor diesem Hintergrund ein HPC-Landeskonzept entwickelt mit dem Ziel, das HPC-Ökosystem in Nordrhein-Westfalen innerhalb des nationalen HPC-Kontexts weiter zu entwickeln.

Die Allianz AHRP ist eine gemeinsame Einrichtung der Universität Mainz und der TU Kaiserslautern. Sie hat das Ziel, die Aktivitäten der beiden Universitäten im Bereich des Hochleistungsrechnens (HLR) zu koordinieren und Kapazitäten zum HLR nach dem jeweiligen Stand der Technik für die Wissenschaftlerinnen und Wissenschaftler des Landes Rheinland-Pfalz nachhaltig bereitzustellen. Zusätzlich zu dem Schulungsangebot wird jährlich ein gemeinsamer Workshop mit dem Hessischen Kompetenzzentrum für Hochleistungsrechnen angeboten.

Der Vienna Scientific Cluster ist ein Zusammenschluss von mehreren österreichischen Universitäten, der seinen Benutzern Zugang zu einem Supercomputer verschafft. Das aktuelle Aushängeschild des VSC, der VSC-5, hat eine Rechenleistung von 4,3 PetaFLOPS und ist deutlich energieeffizienter als sein Vorgänger.